Les internautes surfent de liens en liens au fil de recommandations de plus en plus personnalisées. Mais les critères qui régissent ces suggestions sont opaques et inaccessibles. Après neuf ans passés chez Technicolor, le chercheur Erwan Le Merrer rejoint l’équipe Wide* au centre Inria de Rennes avec un projet dans ses cartons : créer un instrument pour mesurer, de l’extérieur, les critères de recommandation employés par les éditeurs Internet et donner aux utilisateurs une meilleure compréhension des mécanismes à l’œuvre.

En grec ancien, Panoptès signifie “celui qui voit tout”. Dans la mythologie antique, c’était le surnom d’Argos, le dieu aux cent yeux. C’est aussi le nom du projet porté par Erwan Le Merrer. L’objectif : y voir plus clair dans les recommandations proposées par les sites Internet.

Constat de départ : “le web était initialement décentralisé. Il y avait beaucoup de services répartis dans le monde entier. La tendance est maintenant à la concentration au sein d’un tout petit groupe d’opérateurs : les fameux Gafam. Auparavant, quand il cliquait sur un hyperlien, l’internaute surfait d’une page à l’autre, passant d’un opérateur à un autre. Mais ce n’est plus cas. Aujourd’hui, les géants de l’Internet s’efforcent de conserver les utilisateurs le plus longtemps possible sur leur plate-forme. Et ils y parviennent via leurs algorithmes de recommandation.” Conséquence : “les critères qui alimentent ces algorithmes exercent une influence prépondérante sur ce que les gens voient, lisent ou consomment.”

Problème : “ces critères se trouvent de facto placés dans une boîte noire.” Les opérateurs connaissent les ingrédients de la recette, mais pas les utilisateurs. “En conséquence, on peut les influencer subrepticement en leur soumettant certains liens… plutôt que d’autres. D’où les questions croissantes de la société civile sur de possibles tentatives de manipulation de l’opinion. On en a eu une illustration frappante lors de la dernière élection présidentielle aux États-Unis, avec les polémiques autour de l’impact des algorithmes employés par les réseaux sociaux pour classer ou trier l’information.” Sans aller jusque là, “dans la vie quotidienne, les recommandations contribuent aussi à créer un effet de bulle. Elles nous confortent dans nos habitudes de consommation, dans nos préjugés, etc. Nous sommes de moins en moins confrontés à l’altérité, et à des produits, contenus ou opinions différents. Au bout du compte, ce tri a donc un impact fondamental sur nos interactions numériques.”

Transparence algorithmique

Une prise de conscience s’amorce. “Inria contribue d’ailleurs à ce débat via TransAlgo (1). Articulée autour du concept de transparence algorithmique, cette plate-forme cherche à définir ce qu’est un algorithme équitable et non biaisé pour faire des préconisations de bonnes pratiques aux opérateurs.” Le travail d’Erwan Le Merrer s’inscrit dans une optique un peu différente. “Au lieu de tenter de définir un périmètre de bonnes pratiques, je veux plutôt exposer les cas particuliers, afin de permettre aux utilisateurs de décider eux-mêmes s’ils trouvent ces recommandations légitimes ou pas. Ainsi, une fois dûment informés, ils décideront de la pertinence de continuer à utiliser cet opérateur, voire même de faire pression sur lui.”

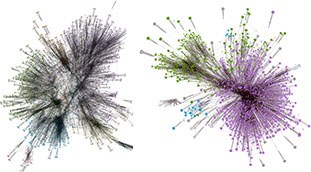

Les graphes de vidéos recommandés par Youtube à un nouvel utilisateur (gauche), et à un utilisateur connu (droite)

Mais pour cela, il faut créer des algorithmes qui font ‘parler’ la boîte noire.“Évidemment, aucun opérateur ne veut divulguer les détails sur ses algorithmes. Ceux-ci constituent le cœur de sa technologie et relèvent du secret industriel. Il faut donc des outils pour observer ces algorithmes de l’extérieur. Et c’est ce que nous avons commencé à développer dans un premier travail avec Gilles Trédan, du CNRS (2). En l’occurrence, nous avons choisi de nous intéresser à la plateforme à succès qu’est Youtube. Avec une question : en observant les recommandations qui y sont faites, peut-on dire si elles semblent légitimes par rapport aux vidéos que l’utilisateur est en train de visionner ?”

Le graphe, un outil prometteur

Pour commencer, les scientifiques avaient besoin d’une structure de données permettant de représenter les recommandations qui s’affichent à raison d’environ 20 par page quand l’internaute clique de lien en lien. “Nous avons proposé d’utiliser une structuration en graphe. Grâce à celui-ci, on voit apparaître des séries de liens plus ou moins en rapport avec la vidéo en cours de visionnage. On peut raisonner topologiquement. Nous avons ainsi pu montrer que si l’utilisateur est inconnu de la plate-forme, lui est proposé une grande variété de communautés de vidéos. En revanche, si l’utilisateur est connu, parce qu’il s’est connecté avec son compte ou qu’il y a un cookie dans son navigateur, alors la plate-forme propose des recommandations ciblées sur son profil, ce que l’on peut mesurer au regard du nombre restreint de communautés. Ce qui entraîne ce fameux effet de bulle. Et on peut le montrer factuellement. À l’aide d’un algorithme, le graphe va aussi nous servir à prédire quels sont, sur la plateforme Youtube, les liens estampillés ‘recommandés pour vous’.

On peut aussi chercher s’il existe des recommandations personnalisées mais qui, sur le site, ne sont pas indiquées comme telles. Nous avons montré que la structure de données graphe permet d’inférer ce type de propriétés. Donc c’est un outil prometteur.”

Le graphe permet de matérialiser ce que l’on appelle des liens courts, c’est-à-dire amenant dans le même thème que la vidéo regardée, ainsi que les liens longs qui, eux, sortent de ce champ thématique. “Quand l’utilisateur est connu, il y a moins de liens longs envoyant vers d’autres centres d’intérêt. C’est logique. La longueur des liens dans le graphe donne une probabilité sur le fait que le lien recommandé ne soit pas en relation directe avec ce qui est visualisé. La longueur du lien donne aussi une information sur la probabilité que le lien ne soit pas légitime à l’instant où l’utilisateur regarde quelque chose.” Et là, les choses sérieuses commencent. “Ce n’est pas à nous de dire si c’est bien ou mal. En revanche, nous souhaitons faire en sorte que l’utilisateur puisse disposer de cette information, prendre conscience du mécanisme à l’œuvre et, à partir de là, effectuer un choix éclairé.”

L’idée va même être poussée plus loin. “Nous souhaitons faire collaborer les utilisateurs et partager à grande échelle l’information sur ces recommandations.” Comment ? “En proposant par exemple un plugin pour navigateur. Grâce à lui, l’utilisateur aura une vision plus générale de ce qui se passe. On pourra par exemple souligner un lien en rouge pour lui signaler qu’il pose question. Il y aura aussi probablement des variations dans le temps, au gré des événements tels que les élections par exemple. On se dirigerait donc vers une sorte de météo de la recommandation.”

|